В настоящее время многие организации используют цифровые системы охранного видеонаблюдения, обычно ограничивающиеся простой установкой камер и работой операторов. При организации видео-

наблюдения с использованием традиционных камер оператору приходится сталкиваться с проблемой плохой видимости наблюдаемого объекта ввиду плохого освещения и погодных условий. Так, при недостаточном освещении в видеопоследовательности возникают шумы, характеризуемые разноцветными точками, хаотично распределенными по экрану, и образуются засвеченные области в случае, если в поле зрения камеры попадает источник освещения. Для решения проблемы плохой видимости могут применяться различные методы цветовой коррекции [1–3] и шумоподавления [1, 4]. Однако при недостаточном уровне освещения данные методы не всегда могут давать приемлемые результаты. В частности, при недостаточном уровне освещения возникающие шумы также будут усилены алгоритмами коррекции освещения.

В последние годы растет популярность инфракрасных камер, позволяющих фиксировать различия тепловой энергии у наблюдаемого объекта и сцены. Это обусловлено тем, что они могут обеспечить

достаточно четкое видео во время неблагоприятных погодных условиях (дождь, туман), а также в условиях недостаточной освещенности (ночью, на рассвете и закате). Благодаря тому, что инфракрасное излучение имеет большую длину волны, чем видимый свет, оно меньше рассеивается частицами в воздухе, что позволяет при использовании IR-камер частично компенсировать воздействие погодных условий на качество получаемого изображения [5]. Помимо этого, инфракрасные камеры полезны, когда имеются засвеченные участки, что может сделать традиционное видео непригодным для использования. Инфракрасные видеоданные в системах видеонаблюдения обычно представляются как оттенки серого, что создает хороший контраст между объектами и их фоном. Однако это не всегда удобно для оператора.

Объединение данных, полученных с помощью инфракрасной (IR) и традиционной (RGB) камер, позволит получить информацию, которую нельзя было бы получить путем просмотра данных по отдельности. Для этой цели могут применяться различные методы слияния инфракрасных и визуальных (RGB) изображений. Характеристики инфракрасных изображений и область их применения определяются типом камер.

Типы инфракрасных камер

Инфракрасное излучение (IR – infrared) – это электромагнитное излучение, длина волны которого больше, чем у видимого света, в диапазоне от 0,76 мкм до 100 мкм. Этот диапазон условно разделяется на следующие составляющие [6]:

– ближний инфракрасный диапазон (NIR – Near Infrared Range) с длиной волны от 0,76 до 1,0 мкм;

– коротковолновый инфракрасный диапазон (SWIR – Short Wavelength Infrared Range) с длиной волны от 1 до 3 мкм;

– средний инфракрасный диапазон (MWIR – Medium Wavelength Infrared Range) с длиной волны от

3 до 6 мкм;

– длинноволновый инфракрасный диапазон (LWIR – Long Wavelength Infrared Range) с длиной волны от 6 до 15 мкм;

– сверхдлинноволновый инфракрасный диапазон (VLWIR – Very Long Wavelength Infrared Range)

с длиной волны от 15 до 30 мкм;

– дальний инфракрасный диапазон (FIR – Far Infrared Range) с длиной волны от 30 до100 мкм.

При использовании NIR- и SWIR-приемников на захватываемых изображениях у объектов есть тени и определенная контрастность, так как захватывается излучение, которое отражается от объектов. При этом объекты выглядят точно так же, как при видимом освещении, с четко различимыми деталями,

а разрешающая способность таких детекторов сопоставима с устройствами захвата, работающими в видимом диапазоне. Так как объекты легко различимы и узнаваемы, NIR и SWIR используют при организации систем видеонаблюдения с возможностью обнаружения и сопровождения объектов интереса. При этом при более длинной волне, чем видимый диапазон света, данные детекторы способны «видеть» сквозь туман, дым и пыль лучше, чем камеры, работающие в видимом диапазоне.

Стоит отметить, что большинство оптических материалов, используемых в обычных камерах, подходят и для NIR, и для SWIR (обычное стекло пропускает излучение до 2,5 мкм), что может существенно снизить стоимость оборудования.

При использовании MWIR и LWIR длина волны излучения больше 3,5 мкм, что влияет на захватываемое изображение, так как оно формируется на основе собственного теплового излучения объектов сцены, которое может не отличаться от теплового излучения фона. При этом уменьшается динамический диапазон изображения, ухудшаются контрастность и узнаваемость объектов.

Устройства, работающие в этом диапазоне длин волн (тепловизоры), имеют высокую стоимость, так как приходится применять специальные материалы для оптики приборов и при необходимости охлаждение детекторов, при этом разрешающая способность у дорогих устройств составляет на текущий момент 1280x1024 пикселей. Данные детекторы применяются во многих областях: ночное видение, инспекция зданий, обеспечение безопасности, контроль качества в производстве товаров, авиация и т.д.

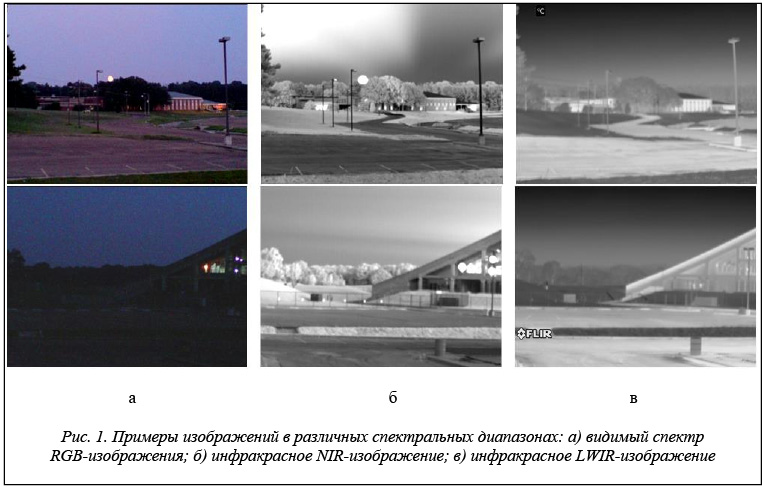

Примеры изображений [7] для различных спектральных диапазонов, полученных в различных условиях освещения – во время заката и в ночное время, представлены на рисунке 1.

Подходы к слиянию инфракрасных и видимых изображений

Методы слияния инфракрасных и видимых изображений можно разделить на три обширных класса в зависимости от уровня объектов, с которыми они работают [8–10]:

– пиксели изображения;

– характерные особенности изображения;

– конкретные объекты изображения.

Слияние на основе пикселей представляет нижний уровень обработки изображений, на котором происходит слияние физических параметров исходных изображений. Наиболее известными подходами попиксельного слияния изображений являются алгоритмы простого усреднения [11], усреднение с весовыми коэффициентами (α-blend), метод переноса хроматических характеристик (color transfer) [12], метод главных компонент (PCA – principal component analysis) [13], слияние с использованием пирамиды изображений [14], вейвлет-преобразование [15]. При использовании данного подхода требуется, чтобы пикпиксели входных изображений имели одинаковое положение на захватываемой сцене, то есть чтобы захват инфракрасного и визуального изображений происходил в одно и то же время и в той же точке сцены.

Слияние на основе характерных особенностей является следующим уровнем обработки входных изображений. На данном уровне сопоставляются ключевые особенности каждого из входных изображений. Такой подход дает лучшие результаты слияния, чем обработка на пиксельном уровне, но требует предварительной подготовки используемых данных. Наиболее распространенными подходами слияния изображений на основе характерных особенностей [16] являются методы на основе выделения границ [17] и искусственные нейронные сети [18].

Слияние на основе выделения объектов на изображении определяет наивысший уровень обработки.

В методах на данном уровне происходит идентификация объектов индивидуально для каждого из входных изображений. Полученная информация комбинируется и используется для точного распознавания наблюдаемых объектов. Если объекты корректно распознаны со всех источников изображений, то происходит их слияние для получения действительного представления сцены. Наиболее распространенными подходами слияния изображений на основе выделения объектов являются алгоритмы нечеткой логики [19], байесовская сеть [20] и алгоритмы машинного обучения [21].

Проанализировав принцип работы алгоритмов на каждом уровне, можно прийти к выводу, что наибольшее быстродействие наблюдается у методов попиксельного слияния.

Методы попиксельного слияния

Наиболее простым методом слияния изображений является слияние на основе сложения данных.

Так, яркость результирующего изображения может быть получена как среднеарифметическое значение инфракрасных (IR) и визуальных (RGB) данных. Помимо вычисления среднеарифметического значения, при расчете результирующей яркости может использоваться максимальное или минимальное значение.

Расширением этого метода является использование весовых коэффициентов, которые будут определять вклад исходных изображений при выполнении слияния. При этом весовые коэффициенты могут быть применены к изображению в целом или корректироваться для каждого пиксела на основе разумного правила. Такой метод иногда называют α-смешиванием (α-blend), поскольку весовой коэффициент представлен альфой, как показано в формуле

INEW(x, y) = α × IRGB(x, y) + (1–α) × IIR(x, y),

где х, у – координаты обрабатываемого пиксела изображений; α – весовой коэффициент слияния; INEW – выходное изображение; IRGB, IIR – входные изображения RGB и IR соответственно.

Существенным недостатком этого метода является занижение контраста при выполнении слияния. Так, если одно из изображений имеет область с равномерной яркостью или низким контрастом, то в результате слияния будет выравниваться контраст в этой области на результирующем изображении. Весовые коэффициенты могут помочь, однако, если задавать их глобально (для всего изображения), то следует учитывать возможные варианты снижения контрастности.

Наиболее часто используемый алгоритм для объединения визуальных (RGB) и инфракрасных изображений типа Near Infrared (NIR) и Short Wavelength Infrared (SWIR) основывается на использовании цветовой модели HSI. К этой модели приводится RGB-изображение, затем его яркостная составляющая заменяется яркостью из NIR-изображения. Данный подход позволяет объединять изображения с большой скоростью, но имеет некоторые недостатки. Темные пиксели NIR-изображения могут не являться таковыми у RGB-изображения, тогда при простой замене яркостей у результирующего изображения понижается интенсивность цветов пикселей или они просто становятся черными. Эта проблема частично решается задействованием насыщенности и яркостной компоненты RGB-изображения:

INEW(x, y) = SaturationRGB × IntensityRGB(x, y) + (1– SaturationRGB) × IntensityIR(x, y).

Однако сформированные таким способом изображения будут отображать растительность (кустарники, деревья и т.п.) в неестественных цветах.

Метод главных компонент (PCA – principal component analysis) позволяет вычислить компактное описание набора данных. Он сводится к вычислению собственных векторов и собственных значений ковариационной матрицы входных данных. Слияние изображений при помощи метода главных компонент происходит следующим образом: входные изображения I1(x, y) и I2(x, y) преобразуются в два вектора-столбца, из которых вычитается их усредненный вектор, далее они комбинируются в матрицу размером n×2, где n – длина вектора-столбца изображения, затем рассчитываются собственные векторы и собственные значения полученной матрицы. В дальнейшем используются собственные векторы (P1, P2), соответствующие максимальным собственным значениям. Непосредственное слияние изображений происходит согласно выражению

Inew(x, y) = P1I1(x, y) + P2I2(x, y).

Дискретное вейвлет-преобразование (DWT – discrete wavelet transform). Во многих аспектах вейвлет-преобразование является аналогом преобразования Фурье. В преобразовании Фурье происходит

декомпозиция сигнала на синусы и косинусы, а вейвлет-преобразование проецирует сигнал на базис, сформированный посредством масштабных изменений и переносов вейвлет-функций. Дискретное вейвлет-преобразование реализуется при помощи пирамидального алгоритма Малла [22]. При слиянии изображений с использованием DWT входные изображения раскладываются на сглаживающие и детализирующие коэффициенты с требуемым уровнем вейвлет-разложения. Далее полученные коэффициенты обоих изображений комбинируются в соответствии с выражением

Inew(x, y) = IDWT [f{DWT(I1(x, y)), DWT(I2(x, y))}],

где I1(x, y), I2(x, y) – входные изображения; f – правило слияния изображений, в данном случае усреднение сглаживающих коэффициентов и выборка детализирующих коэффициентов в каждом диапазоне с наибольшей величиной; IDWT – обратное дискретное вейвлет-преобразование.

Предлагаемый алгоритм

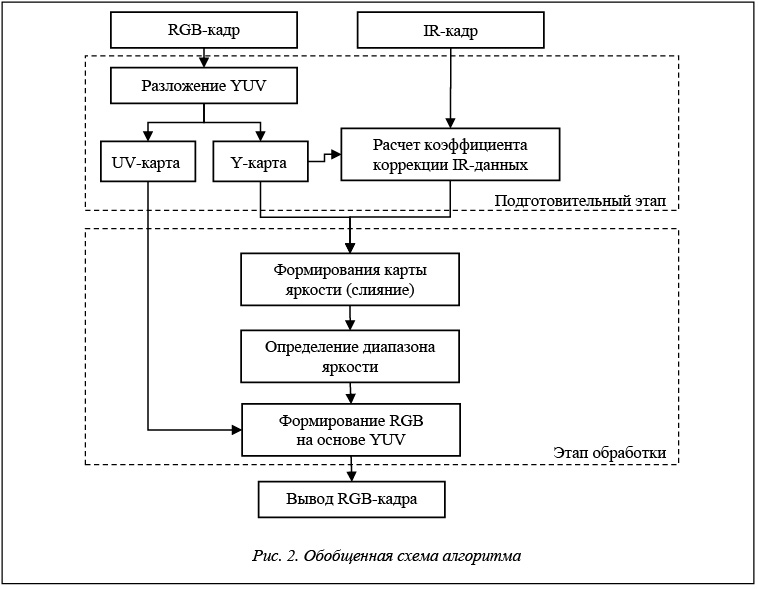

Поскольку в системах видеонаблюдения один из значимых факторов – скорость обработки, основой предлагаемого алгоритма является попиксельная обработка. Так, для улучшения визуального качества видеопоследовательности с использованием инфракрасных данных предлагается алгоритм, обобщенная схема которого представлена на рисунке 2.

Условно данный алгоритм можно разделить на два основных этапа – подготовительный и этап обработки. В ходе подготовительного этапа формируются данные, необходимые для выполнения слияния,

а на этапе обработки происходит формирование улучшенного визуального изображения.

В самом начале подготовительного этапа при считывании изображений кадров формируются гистограммы яркости HistRGB визуального ряда и HistIR для данных инфракрасной съемки и одновременно рассчитываются значения средней яркости AvgIRGB и AvgIIR. При этом параллельно с формированием гистограммы яркости визуального ряда происходит генерация карт хроматических компонент и карты яркости с использованием цветовой модели YUV.

Выполнение попиксельного слияния с учетом весовых коэффициентов позволяет улучшить визуальное качество, однако, если используются изображения, сильно отличающиеся по яркостному представлению, то можно наблюдать затемнение или же, наоборот, осветление участков изображения, а также снижение уровня контрастности. Важным фактором является и тип инфракрасного изображения. Так,

в ходе анализа исходных данных было выяснено, что в условиях недостаточной освещенности средняя яркость инфракрасного изображения LWIR зачастую меньше, чем у визуального ряда, а у изображений NIR и SWIR больше. Принимая это во внимание, было решено осуществить корректировку инфракрасных данных перед слиянием.

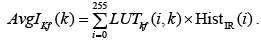

Поскольку интенсивность пикселей находится в диапазоне от 0 до 255, для ускорения расчетов предлагается проводить обработку с использованием таблиц перекодировки (LookUp Table – LUT).

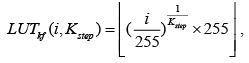

В связи с тем, что разные типы инфракрасных изображений обладают различными характеристиками, необходимо генерировать таблицы перекодировки с учетом этих особенностей. Так, формирование таблицы перекодировки для LWIR-изображений предлагается осуществлять по формуле

где Kstep – коэффициент преобразования.

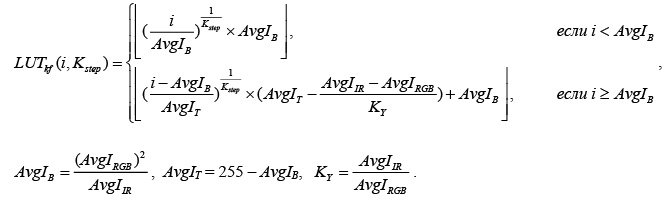

Эта же формула может быть использована для NIR- или SWIR-изображений, средняя яркость которых меньше, чем у RGB-изображения. Однако, если используются инфракрасные изображения, средняя яркость которых AvgIIR превышает AvgIRGB, таблица перекодировки задается по следующей формуле:

В свою очередь, вычисление среднего значения яркости на основе оригинальной гистограммы и таблицы перекодировки AvgIKf(k) будет выполняться согласно выражению

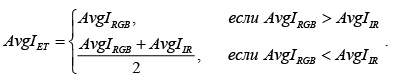

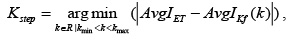

Для выполнения коррекции визуального (RGB) изображения необходимо определить значение коэффициента коррекции яркости инфракрасного изображения (Kstep), при котором отклонение средней яркости AvgIKf(Kstep) минимально отличалось бы от значения эталонной яркости AvgIET. Значение эталонной яркости зависит от яркости визуального изображения и вычисляется согласно условию

Расчет коэффициента коррекции Kstep осуществляется по формуле

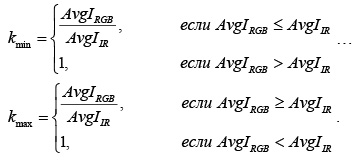

где kmin, kmax – минимально и максимально возможные значения для коэффициента коррекции, определяемые следующим образом:

В связи с этим формирование скорректированного значения яркости инфракрасного изображения (YIr) будет осуществляться следующим образом:

YIR = LUTIR[IIr] = LUTkf(IIr, Kstep),

где IIr – оригинальное значение интенсивности (яркости) инфракрасного изображения; LUTIR – таблица перекодировки для инфракрасного изображения.

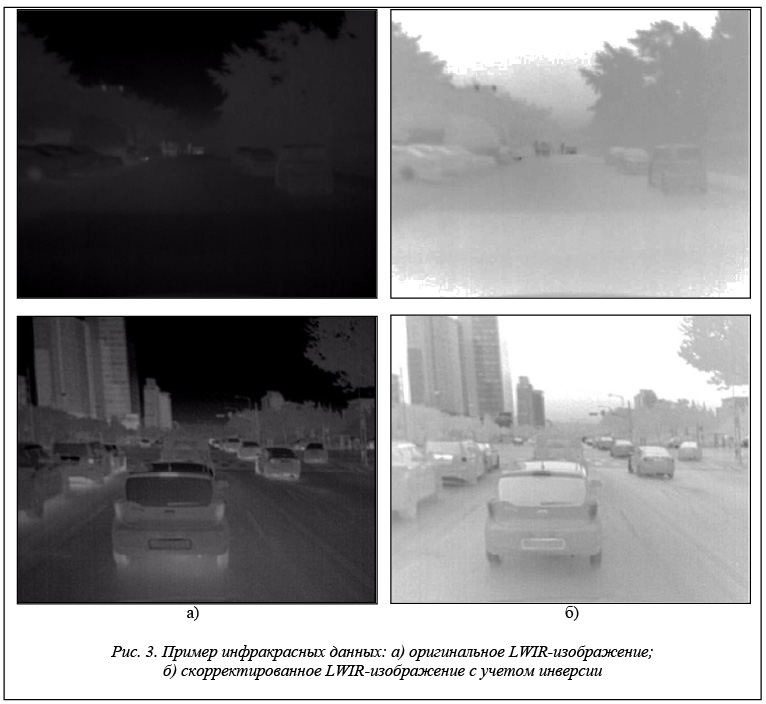

Во время экспериментального исследования было выяснено, что в случае использования

LWIR-изображений для повышения визуального качества видеопоследовательностей с низким уровнем освещения (вечер/ночь/утро) целесообразно использовать скорректированное значения яркости инфракрасного изображения в инвертированной форме. Это связано с тем, что инвертированное инфракрасное изображение более приемлемо для человеческого восприятия (рис. 3). Итоговая таблица перекодировки для инфракрасного LWIR-изображения с учетом инвертирования значения будет генерироваться следующим образом:

LUTIR[I] = 255 – LUTkf(I, Kstep)],

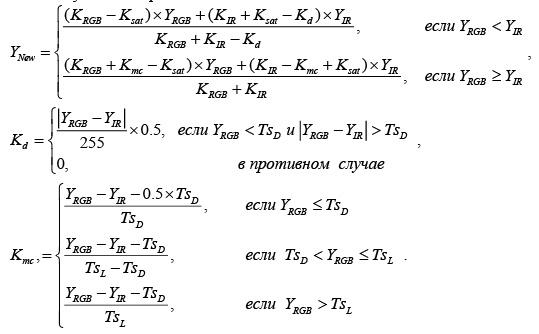

После завершения подготовительного этапа происходит формирование карты яркости путем попиксельного слияния на основе весовых коэффициентов. В предлагаемом алгоритме слияние осуществляется в зависимости от яркости пиксела RGB-изображения YRGB и скорректированного значения яркости инфракрасного изображения. При этом весовые коэффициенты для каждого изображения в каждом пикселе вычисляются динамически и учитывают такие показатели, как разница яркости пиксела у изображений и насыщенность пиксела RGB-изображения. В общем виде расчет нового значения яркости можно представить следующим выражением:

где TsD – порог определения темной области спектра; TsL – порог определения светлой области спектра; KRGB, KIR – значения базовых весовых коэффициентов для RGB- и IR-изображений соответственно.

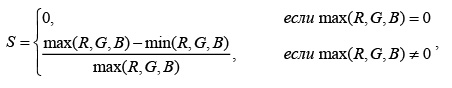

Значение насыщенности, используемое для подстройки коэффициентов, вычисляется согласно цветовой модели HSV по формуле

где R, G, B – значения цветовых каналов модели RGB.

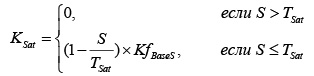

Величина коэффициента насыщенности Ksat определяется по формуле

где TSat – пороговое значение насыщенности цвета; S – насыщенность цвета; KfBaseS – базовое значение коэффициента влияния насыщенности цвета.

Одновременно с вычислением нового значения яркости пересчитываются минимальное (Ymin) и максимальное (Ymax) значения для определения динамического диапазона.

Если динамический диапазон яркости будет меньше предусмотренного в компьютерной графике (0–255), перед формированием RGB-изображения производится дополнительная корректировка значения яркости пиксела для расширения диапазона по формуле

Непосредственное формирование улучшенного изображения осуществляется на основе перевода значений цветовой модели YUV в RGB. При этом используется новое значение яркостной компоненты и от оригинального изображения берется карта хроматических данных.

Сравнение с существующими решениями

Сравнение предлагаемого адаптивного алгоритма осуществлялось с такими алгоритмами цветокоррекции, как Retinex [2], для которого была взята реализация графического редактора Gimp, и модифицированный Multiscale Retinex [1]. Дополнительно проведено сравнение с широко распространенными

методами попиксельного слияния на основе вычисления среднего и максимального значений, а также использование статически заданных взвешенных коэффициентов (α-blend). Для инфракрасных изображений NIR осуществлено сравнение с методом слияния, использующим цветовую модель HSI.

Для выполнения экспериментального исследования с инфракрасными изображениями LWIR использовались тестовые базы KAIST Multispectral Pedestrian Dataset [23] и Litiv Dataset [24]. В базе KAIST Multispectral Pedestrian Dataset содержатся 12 наборов пар инфракрасных и визуальных изображений с разрешением 640×480, полученных в различных условиях освещения. При этом захват данных происходит из автомобиля.

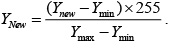

Изображение на рисунке 4 взято из набора KAIST set07 V002.seq, данные которого получены в вечернее время суток, при этом в последовательности наблюдается относительно равномерное освещение.

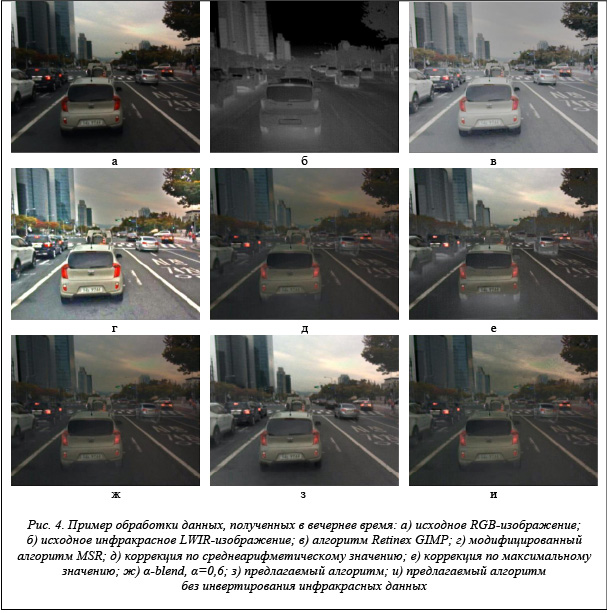

На рисунке 5 показаны примеры обработки ночной сцены, полученной из набора KAIST set03 V000.seq.

В данной последовательности наблюдаются значительная неравномерность освещения и наличие шумов.

Как можно заметить по рисунку 4, предлагаемый алгоритм формирует достаточно качественное изображение, на котором можно различать детали объектов, и при этом не искажаются светлая область (небо) и естественные цвета сцены, как в случае с применением алгоритмов на основе технологии Retinex. В случае применения предлагаемого алгоритма, но невыполнения инвертирования инфракрасных данных можно наблюдать ряд артефактов в области неба. Это связано с тем, что небо на

LWIR-изображении (рис. 4.б) имеет почти черный цвет.

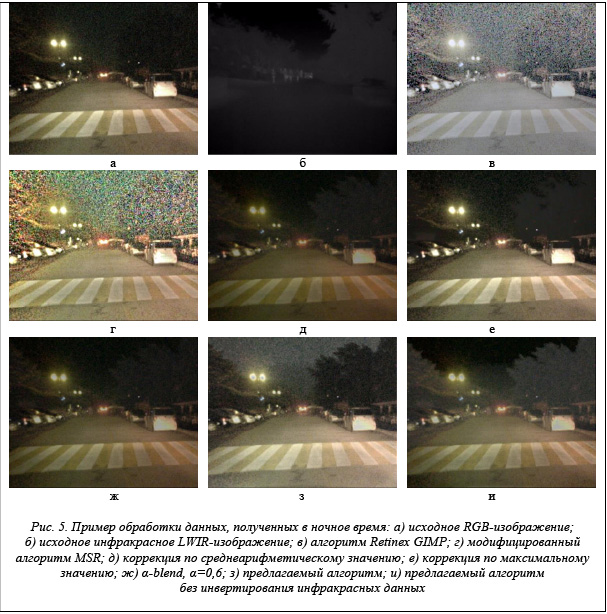

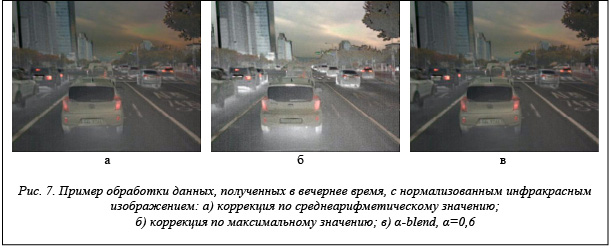

На основе анализа результатов обработки ночных сцен можно сделать заключение, что алгоритмы на основе технологии Retinex не только делают более светлой сцену, но и усиливают шум (рис. 5в, 5г), возникающий в камерах при недостаточном уровне освещения. Результаты алгоритмов попиксельного слияния на основе среднеарифметического и максимального значений, а также α-blend показывают наихудшие результаты с точки зрения визуального восприятия. Это связано с тем, что интенсивность инфракрасного LWIR-изображения очень низкая. Улучшение результатов работы этих алгоритмов возможно за счет предварительной корректировки исходного LWIR-изображения. Корректировка может выполняться на нормализации или же путем растяжения контрастности. Однако даже в таком случае наблюдаемая ночная сцена (рис. 6) по визуальному качеству уступает предложенному алгоритму. Аналогичная ситуация характерна и для вечерней сцены (рис. 7).

Слияние по среднеарифметическому значению и алгоритм α-blend с α=0,6 для ночной сцены дают схожий результат с тем, что и предлагаемый алгоритм без выполнения инвертирования скорректированной яркости инфракрасного изображения.

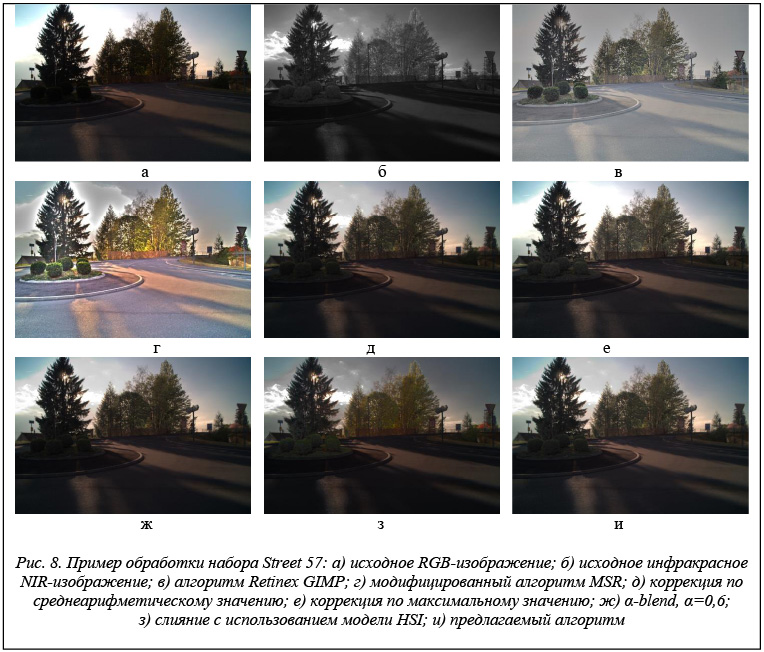

Для тестирования алгоритма по работе с инфракрасными изображениями NIR была использована тестовая база IVRL – RGB-NIR Scene Dataset [25]. В ней представлены 477 пар изображений, разделенных на девять категорий. В качестве демонстрационных примеров выбраны изображения из категории Street. Так, на рисунке 8 представлена сцена, снятая во время восхода солнца, где наблюдается сильный засвет. Из-за особенностей съемки дерево, попадающее на линию света, выглядит очень темным, кусты на клумбе в тени почти не различимы. Инфракрасные данные NIR этой сцены (рис. 8б) позволяют пользователю увидеть, что было засвечено, а также разглядеть растительность (кусты на клумбе и деревья на заднем плане). Средняя яркость инфракрасного изображения в данном тестовом наборе ниже, чем у визуального RGB-изображения.

Как можно заметить из примера, алгоритмы на основе технологии Retinex позволяют разглядеть все детали объектов, находящихся в тени, но не способны исправить засвеченную область изображения, и при этом происходит искажение цветов. Так, алгоритм Retinex редактора GIMP значительно снижает насыщенность цветов, и изображение выглядит блеклым. В свою очередь, модифицированный алгоритм MSR, наоборот, повышает насыщенность цветов. Алгоритм, выполняющий слияние на основе максимального значения, значительно повышает визуальное качество в затененных областях, однако не справляется с устранением засвета. Слияние с использованием модели HSI делает различимым детали и при этом показывает, что было в засвеченной области. Однако у него проявляется недостаток в виде снижения уровня яркости в области с низкой насыщенностью и растительность приобретает неестественный цветовой оттенок. Слияние как на основе среднеарифметического значения, так и алгоритмом α-blend дает более естественную сцену, но при этом объекты, попавшие в тень дерева (кустарник на клумбе), выглядят темнее по сравнению со слиянием на основе максимального значения. Предложенный алгоритм демонстрирует лучшее визуальное качество, он дает естественные цвета сцены и при этом в большей степени возможность разглядеть объекты, попавшие в тень.

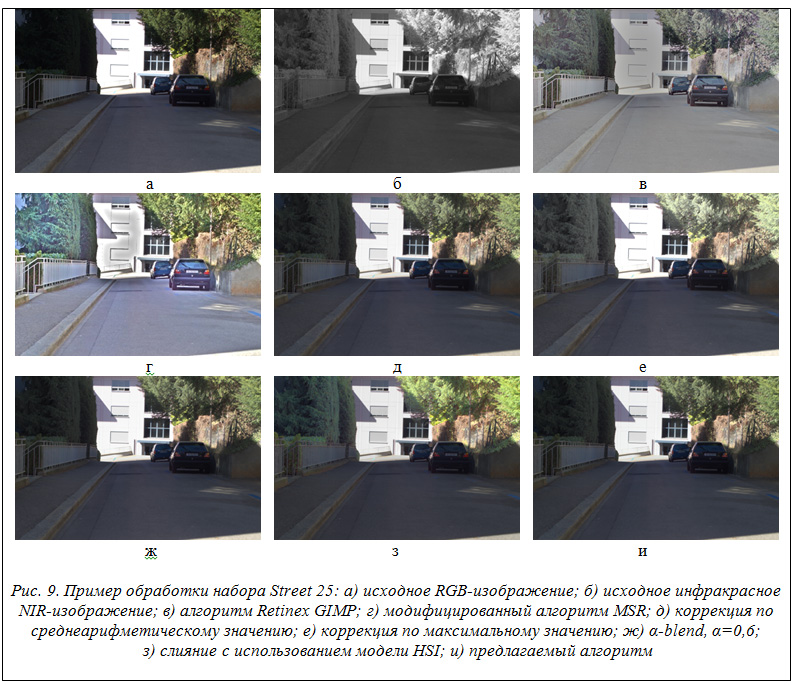

Работа предлагаемого алгоритма в условиях, когда средняя яркость инфракрасного изображения выше, чем у визуального, продемонстрирована на рисунке 9 (набор Street № 25). На этом рисунке показана сцена, снятая в дневное время, на которой живая изгородь, расположенная в левой части, попадает в тень и плохо различима на визуальном изображении, но хорошо видна на инфракрасном. Также на визуальном изображении есть засвеченная область, фрагменты объектов в которой хорошо различимы в инфракрасном диапазоне.

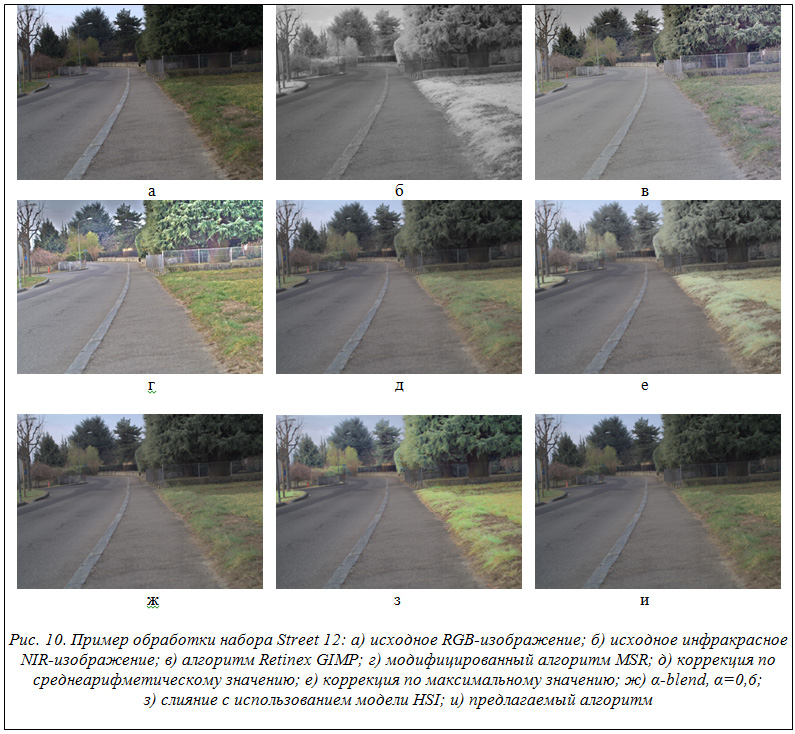

Анализируя рисунок 9, можно заметить, что для алгоритмов характерны те же особенности, что и в случае сцены, представленной на рисунке 8. Примеры, показанные на рисунках 8 и 9, имеют дефекты съемки, связанные с засветом областей и значительным перепадом яркости для отдельных участков. Для оценки влияния алгоритма на визуальное качество изображения, полученного в нормальных условиях, был взят набор Street № 12 (рис. 10). В данном примере единственным участком, в котором затруднено наблюдение для оператора, является область за оградой возле деревьев. Анализируя результаты применения рассматриваемых алгоритмов, можно прийти к выводу, что все они дают хорошие результаты для оператора, однако большинство из них вносят искажения в хроматические параметры изображения и цвета становятся неестественными. Помимо предлагаемого алгоритма, естественные оттенки в наблюдаемой сцене дают только коррекция по среднеарифметическому значению и α-blend.

В ходе экспериментального исследования выявлено, что вне зависимости от типа инфракрасного изображения наибольшее повышение визуального качества достигается при значениях базовых коэффициентов KRGB=3, KIR=2 и пороговых значениях, определяющих темные и светлые участки изображения, TsD=80, TsL=210. Базовое значение коэффициента влияния насыщенности цвета и пороговое значение насыщенности цвета для LWIR-изображений – TSat=0,3 KfBaseS=0,2. В случае использования инфракрасных изображений NIR пороговое значение TSat рекомендуется брать в диапазоне от 0,4 до 0,7, а значение коэффициента KfBaseS – от 0,2 до 0,5.

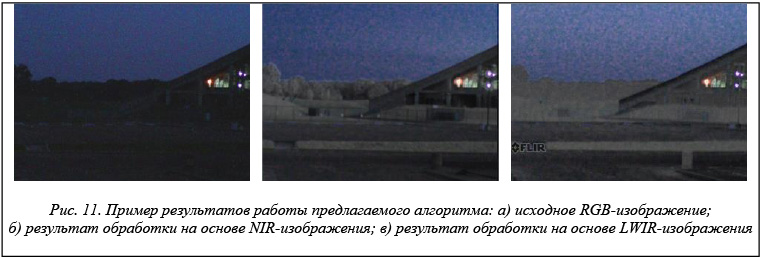

Для выяснения, какой же тип инфракрасного изображения (LWIR или NIR) дает наилучший результат с точки зрения улучшения визуального качества, было выполнено сравнение на примере ночной сцены из рисунка 1. Пример работы предлагаемого алгоритма для этой сцены представлен на рисунке 11.

Проанализировав результат, можно сделать вывод, что инфракрасные NIR-изображения дают более высокое визуальное качество. Это связано непосредственно с характеристиками инфракрасных изображений и особенностями их формирования.

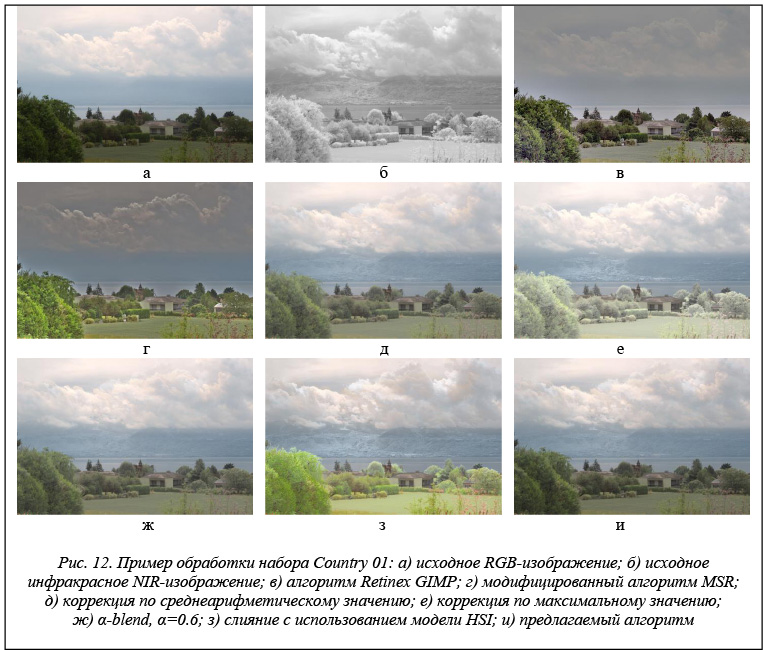

Принимая во внимание особенности инфракрасных изображений типа NIR, было решено проверить возможности предлагаемого алгоритма по устранению эффекта дымки. Данный эффект возникает при наблюдении объектов на значительном расстоянии, иногда его называют и эффектом тумана. Рассмотрим на примере набора Country № 01 (рис. 12) результаты, которые дают различные алгоритмы.

Как можно заметить из рисунка, в видимом спектре (рис. 12а) очертание горного рельефа достаточно трудно различить. Инфракрасное изображение типа NIR, напротив, дает четкое представление о наблюдаемом рельефе. Так, применение алгоритмов семейства Retinex к данной сцене не позволяет восстановить очертания рельефа местности на заднем плане. При этом эти алгоритмы значительно увеличивают локальную контрастность объектов на переднем плане, а также снижают общий уровень средней яркости. Алгоритм, использующий слияние на основе цветовой модели HSI, формирует наиболее четкое представление о рельефе на заднем плане, но вместе с этим он вносит существенные искажения в хроматические параметры изображения. Получаемое изображение имеет сильно перенасыщенные оттенки в области зеленых насаждений на переднем плане (рис. 12з). Наилучший результат с позиции сохранения естественных оттенков цветов и возможности четко видеть детали рельефа на заднем плане дают предлагаемый алгоритм и алгоритм α-blend.

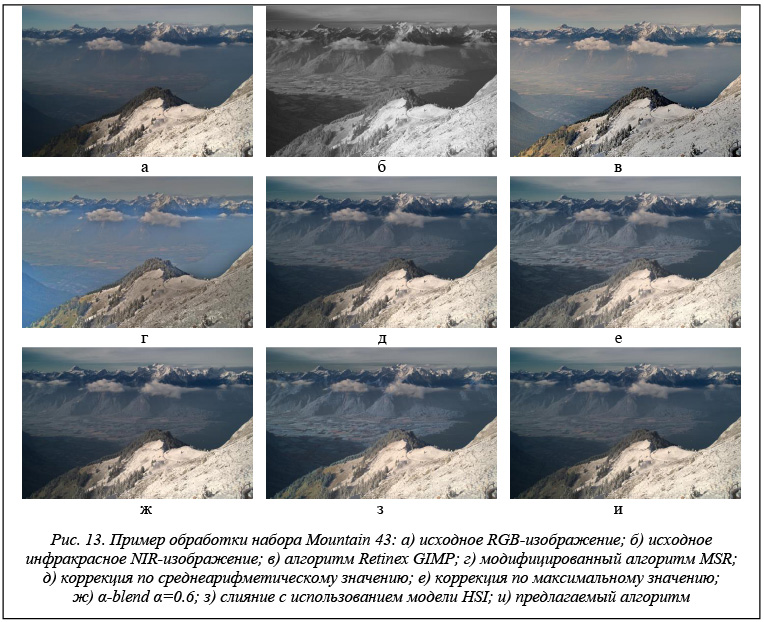

Дополнительно было проведено экспериментальное исследование на наборах серии Mountain. Так, на рисунке 13 представлены результаты обработки набора Mountain № 43. В наблюдаемой сцене можно заметить естественный туман в долине, окруженной горным массивом, который скрывает фрагменты построек и возделываемых участков (их можно наблюдать на инфракрасных снимках).

Алгоритм Retinex, реализованный в редакторе GIMP, дает хороший результат, однако часть территории остается покрытой условной «пеленой», то есть полностью подавить влияние тумана не удалось.

В случае модифицированного алгоритма MSR наблюдается существенное искажение хроматических параметров изображения, что говорит о нецелесообразности его использования для подобных сцен. Предлагаемый алгоритм демонстрирует достаточное улучшение изображения, и при этом не нарушаются яркостные и хроматические характеристики изображения. Наилучший результат с позиции наблюдателя дают алгоритмы слияния с использованием модели HSI и коррекции по максимальному значению. Однако в случае применения слияния в модели HSI наблюдается искажение хроматических характеристик.

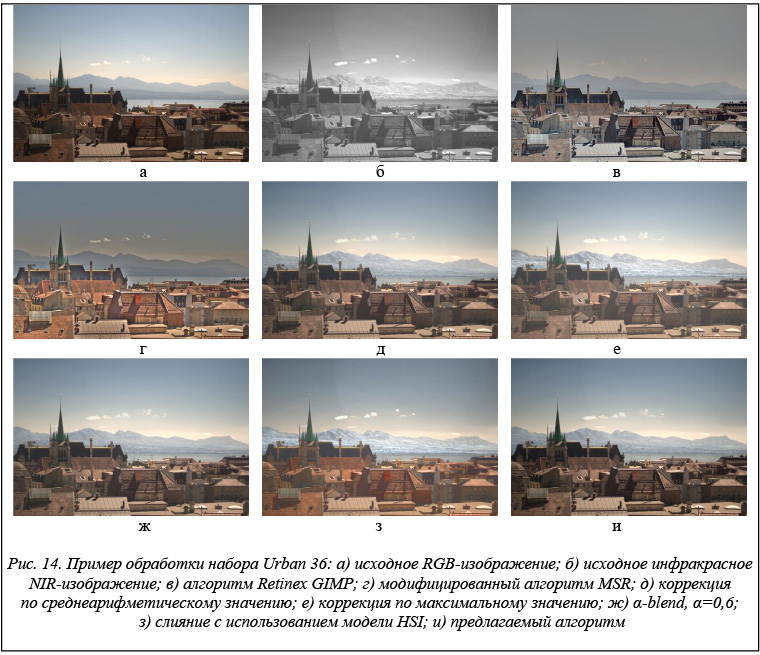

Для оценки обработки изображений, в которых на переднем плане имеется много контрастных объектов с высокой детализацией, был выбран набор Urban № 36 (рис. 14). В наблюдаемой сцене большую часть занимают фрагменты зданий с черепичными крышами, на заднем плане прослеживаются холмы и невысокие горы.

При обработке данной сцены алгоритмы на основе технологии Retinex не смогли снизить эффект

тумана. Классические алгоритмы слияния на основе среднеарифметического значения и α-blend демонстрируют хорошие результаты. Так, различим рельеф местности на заднем плане, сохранены естественные цветовые оттенки, но при этом есть незначительные изменения яркостных характеристик, занижающие контрастность изображения. В свою очередь, предлагаемый алгоритм дает наилучший результат, поскольку не занижается контрастность, и сцена выглядит естественно. Наиболее четко задний план просматривается на изображениях после слияния на основе модели HSI и коррекции по максимальному значению. Однако в случае их применения нарушается яркостной баланс, а также для модели HSI происходит искажение хроматических характеристик.

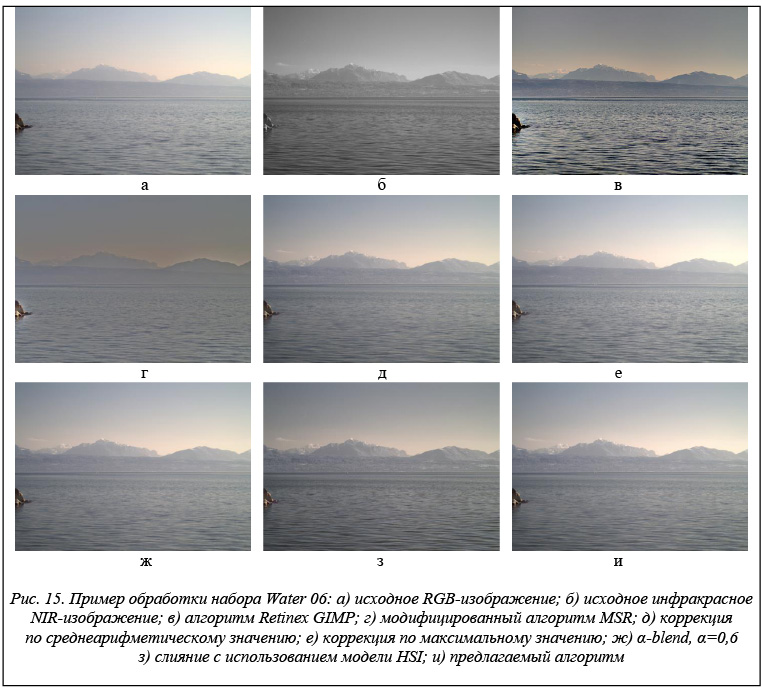

На рисунке 15 представлены результаты обработки водной сцены из набора Water № 06. На данном рисунке представлена сцена, где на переднем плане водная поверхность, а на заднем – холмы и горы, плохо различимые на RGB-изображении, но хорошо видные в инфракрасном спектре.

Проанализировав результаты обработки набора Water № 06, можно прийти к выводу, что для данной сцены алгоритм Retinex, реализованный в графическом редакторе GIMP, позволяет сформировать изображение водной поверхности с достаточно высоким значением локальной контрастности и при этом отчасти улучшает возможность наблюдения рельефа местности на заднем плане. Модифицированный алгоритм MSR для данной сцены демонстрирует наихудший результат, поскольку значительно снижает средний уровень локальной контрастности. Наилучшим алгоритмом обработки данной сцены является алгоритм слияния с использованием модели HSI. Остальные алгоритмы дают схожие результаты.

Таким образом, можно сделать следующие выводы. Инфракрасные камеры относительно недавно получили широкое распространение на потребительском рынке. Поэтому появилась возможность задействовать их преимущества (ночная съемка, независимость от погодных условий, таких как туман и дым) наряду с преимуществами камер, работающих в визуальном спектре (высокие разрешения, позволяющие задействовать в анализе текстурные и цветовые характеристики объектов). Использование мультиспектральных изображений позволяет скомбинировать преимущества обоих типов камер, сделать захват изображения частично не зависимым от погодных условий и условий освещения. Представленный в данной работе адаптивный алгоритм попиксельного слияния входных визуальных и инфракрасных изображений продемонстрировал свою состоятельность. Алгоритм может работать как с инфракрасными снимками типа NIR, так и с LWIR. Определенный в ходе экспериментального исследования набор параметров позволяет получать качественный результат независимо от типа инфракрасного изображения. В ходе экспериментального исследования была определена возможность использования предлагаемого алгоритма для решения разных целевых задач. Так, при использовании данных типа NIR алгоритм хорошо справляется с задачами улучшения визуального качества при наличии контрастных областей, засветов и эффекта тумана. При обработке материала, отснятого в ночное время с использованием данных LWIR, удалось получить лучшие результаты по сравнению с алгоритмами на основе технологии Retinex и с классическими алгоритмами слияния изображений.

Литература

- Зотин А.Г., Пахирка А.И., Буряченко В.В. Система видеонаблюдения c возможностью улучшения визуального качества видеопотока // Программные продукты и системы. 2013. № 2. С. 191–197.

- Petro A., Sbert C., Morel J-M. Multiscale Retinex. IPOL Journ., 2014, pp. 71–88.

- Chao An, Mei Yu. Fast color image enhancement based on fuzzy multiple-scale Retinex. Strategic Technology (IFOST). Proc. 6th Intern.l Forum, Harbin, Heilongjiang, 2011, pp. 1065–1069.

- Зотин А.Г., Пахирка А.И. Адаптивный алгоритм шумоподавления в системах видеонаблюдения при низком уровне освещения сцены // Цифровая обработка сигналов и ее применение (DSPA 2016): докл. 18-й Междунар. конф. М., 2016. Т. 2. С. 838–843.

- Karlsson J. FPGA-Accelerated Dehazing by Visible and Near-infrared Image Fusion, 2015. URL: http://www.idt.mdh.se/utbildning/exjobb/files/TR1580.pdf (дата обращения: 31.03.2016).

- Rogalski A. Infrared Detectors, Second Edition. CRC Press, Taylor & Francis Group, Boca Raton. Florida, USA, 2011, 898 p.

- Zheng Y. An Exploration of Color Fusion with Multispectral Images for Night Vision Enhancement, Image Fusion and Its Applications. Image Fusion, 2011. URL: http://www.intechopen.com/books/image-fusion-and-its-applications/an-exploration-of-color-fusion-with-multispectral-images-for-night-vision-enhancement (дата обращения: 29.03.2016).

- Zin T., Takahashi H., Hiromitsu T. Fusion of Infrared and Visible Images for Robust Person Detection. Image Fusion, Osamu Ukimura (Ed.), 2011, pp. 239–264.

- Malviya A., Bhirud S.G. Image Fusion of Digital Images. Intern. Journ. of Recent Trends in Engineering, 2009, vol. 2, no. 3, pp. 146–148.

- Nikolakopoulos G.K. Comparison of Nine Fusion Techniques for Very High Resolution Data. Photogrammetric Engineering & Remote Sensing, 2008, vol. 74, no. 5, pp. 647–659.

- Khaleghi B., et al. Multisensor Data Fusion: A Review of the State-of-the-Art. Information Fusion, 2013, vol. 14, pp. 28–44.

- Firouz A. Al-Wassai, Dr. N.V. Kalyankar, Dr. A.A. Al-zuky. The IHS Transformations Based Image Fusion. Journal of Global Research in Computer Science, 2011, vol. 2, no. 5, pp. 70–77.

- Wang Z, Deller JR, Jr., Fleet BD; Pixel-level multisensor image fusion based on matrix completion and robust principal component analysis. Journ. Electron. Imaging, 2015, vol. 25, no. 1. URL: http://electronicimaging.spiedigitallibrary.org/article.aspx?articleid=2482741 (дата обращения: 29 03.2016).

- Wang W., Chang F. A Multi-focus Image Fusion Method Based on Laplacian Pyramid. Journ. of Computers, 2011, vol. 6, no. 12, pp. 2559–2566.

- Pajares G., Cruz J.M. A wavelet-based image fusion tutorial. Pattern Recognition, 2004, vol. 37, no. 9, pp. 1855–1872.

- Liu Y., Liu S., Wang Z. Multi-focus image fusion with dense SIFT. Information Fusion, 2015, vol. 23, pp. 139–155.

- Ehlers M., Tomowski D. On segment based image fusion. Springer Berlin Heidelberg, 2008, pp. 735–754.

- Li-Qun Gao, Rong Wang, Shu Yang. An image fusion algorithm based on RBF neural networks. Machine Learning and Cybernetics, 2005, vol. 8, pp. 5194–5199.

- Zheng Y., Zheng P. Multisensor image fusion using fuzzy logic for surveillance systems. Fuzzy Systems and Knowledge Discovery (FSKD), 2010, pp. 588–592.

- Smaili C.C., Najjar M.E., Charpillet F. Multi-sensor Fusion Method Using Dynamic Bayesian Network for Precise Vehicle Localization and Road Matching. Tools with Artificial Intelligence, 2007, pp. 146–151.

- Tomowski D., Ehlers M., Michel U., Bohmann G. Decision based data fusion techniques for settlement area detection from multisensor remote sensing data. 1st EARSeL Workshop of the SIG Urban Remote Sensing Humboldt-Universität zu Berlin, 2006, pp. 1–8.

- Малла С. Вэйвлеты в обработке сигналов; [пер. с англ.]. М.: Мир, 2005. 672 с.

- KAIST Multispectral Pedestrian Dataset. URL: https://sites.google.com/site/pedestrianbenchmark/home (дата обращения: 29.03.2016).

- Litiv Dataset. URL: http://www.polymtl.ca/litiv/en/vid/ (дата обращения: 29.03.2016).

- IVRL – RGB-NIR Scene Dataset. URL: http://ivrl.epfl.ch/supplementary_material/cvpr11/ (дата обращения: 29.03.2016).

VISUAL QUALITY ENHANCEMENT OF THE IMAGE BASED ON INFRARED DATA IN VIDEO

SURVEILLANCE SYSTEMS

(The work is done with support from the Russian Foundation for Basic Research, project no. 16-07-00121 А)

Zotin A.G., Ph.D. (Engineering), Associate Professor, zotinkrs@gmail.com;

Pakhirka A.I., Ph.D. (Engineering), Assistant Professor, pahirka@sibsau.ru;

Damov M.V., Ph.D. (Engineering), Assistant Professor, me@damov.pro;

Savchina E.I., Undergraduate, oreshkinaei@gmail.com

(Academician M.F. Reshetnev Siberian State Aerospace University,

Krasnoyarsky Rabochy Ave. 31, Krasnoyarsk, 660014, Russian Federation)

Abstract. Video surveillance systems are increasingly beginning to use sensors which working in the infrared spectrum. Infrared cameras are widespread nowadays. However, the video surveillance operator often faces the problem of poor visibility of the observed object. This occurs in low light (night, twilight) and adverse weather conditions (haze, smoke, dust).

In this article the methods of the visual quality enhancement of the images obtained in bad lighting conditions are considered. Fusion of visual data (RGB) and infrared (IR) images are used to enhancement of images visual quality.

Fusion methods can be divided into three main categories according to the principle of their operation: pixel fusion, features fusion and object based fusion. The speed of data processing is very important in video surveillance systems. The images are fused in the transform domain using novel pixel-based rules.

The proposed algorithm is divided into two main stages – preparation and processing. During the preparation stage the data necessary to carry out the fusion are calculated. The formation of the chromatic components map of YUV color model is conducted at this stage. To enhance the visual quality we offer to perform the adjustment of the infrared image, depending on its type (NIR SWIR and LWIR) and average brightness value. To determine the correction factor is proposed to use histograms and lookup tables, which can significantly reduce the computational complexity of the algorithm.

At the processing stage the formation of the fused image with enhanced visual quality is carried out. During fusion the adaptation of fusion coefficients is conducted for each pixel. It is based on such parameters as brightness values of pixels of visual and corrected infrared images, as well as information of color saturation.

Experimental results on LWIR and NIR infrared data shows that images fused by proposed algorithm demonstrated better spectral features than the original ones.

Keywords: image processing, image analysis, infrared image, Retinex, LWIR, NIR, image fusion.

Комментарии