Повышение эффективности современных систем видеонаблюдения позволяет снизить трудозатраты персонала. Однако в большинстве случаев применение таких систем ограничивается простой установкой видеокамер, при этом оператору необходимо постоянно следить за происходящим на нескольких камерах, данные с которых могут отображаться на множестве мониторов. Поэтому наряду с внедрением систем видеонаблюдения на автостоянки, заправочные станции, перекрестки со сложным движением требуется осуществлять аналитическую поддержку таких систем. Возникает потребность в использовании детекторов движения, в наличии удобного пользовательского интерфейса, позволяющего интуитивно следить за несколькими камерами, а также системы сигналов для оператора, привлекающей внимание к определенной ситуации на мониторе, в анализе движения объектов и их параметров. К тому же следует учесть, что при организации видеонаблюдения на открытой местности часто возникают проблемы, связанные с неблагоприятными погодными условиями.

Основным требованием к системам видеонаблюдения является ведение журнала событий в виде набора кадров или видеопоследовательностей, на которых запечатлены нарушители, с одновременным оповещением оператора. Функционирование блока, выполняющего эти действия, основано на работе детектора движения, однако в большинстве существующих систем используется детектор движения, интегрированный в камеры. Это приводит к тому, что необходимо очень тщательно подбирать параметры определения движения для снижения вероятности ложного срабатывания. При программной реализации детектора движения возможно использование адаптивных алгоритмов и алгоритмов, учитывающих предварительную обработку в виде стабилизации, цветовой и яркостной коррекции.

Предлагаемые алгоритмы предназначены для улучшения качества видеоматериала, полученного в сложных условиях освещения, при организации видеонаблюдения на АЗС, парковках, дворах и т.п. Трехступенчатый детектор движения позволяет выделить три вида движения в кадре: нет движения, слабое и сильное движение. В связи с проблемами детекторов движения, а именно большой чувствительностью к погодным условиям, дрожанию камеры и незначительным помехам в кадре, предлагается алгоритм стабилизации видео, позволяющий значительно повысить устойчивость к таким эффектам. Применение временной фильтрации и метода MSR для повышения качества цветных изображений позволяет улучшить качество восприятия видеоданных в вечернее время суток, а также снизить влияние помех от самих камер.

Для разработки системы использовался модульный подход, поскольку применение модульной организации при реализации системы позволяет в дальнейшем с минимальными вложениями выполнять модернизацию или расширение системы в целом. Также модульная архитектура предоставляет более широкие возможности по отладке и изучению алгоритмов.

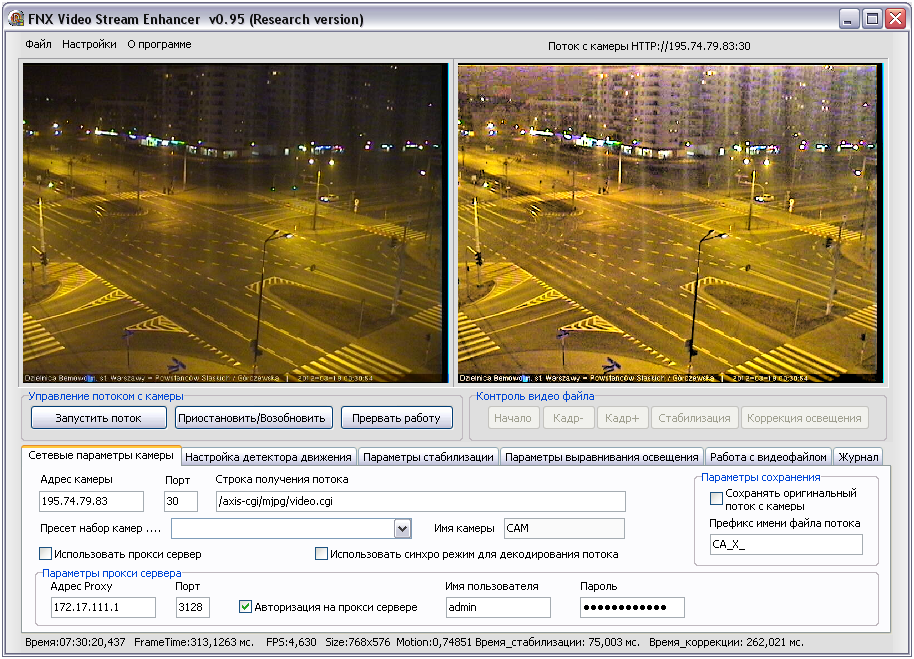

Основными модулями предлагаемой системы видеонаблюдения являются модули улучшения качества изображения, детектора движения и стабилизации видео. Кроме них, с ядром системы связаны модуль получения видеопотока, который получает данные с IP-камеры или из файла, а также модуль пользовательского интерфейса (рис. 1). Экранная форма исследовательского варианта экспериментальной системы видеонаблюдения представлена на рисунке 2.

Оценка движения

Наиболее значимым в системах видеонаблюдения является модуль детектора движения, поскольку при обнаружении движения появляется необходимость в привлечении внимания оператора. На сегодняшний день существует большое количество методов обнаружения движения, однако многие из них достаточно сложны с вычислительной точки зрения. К самым быстродействующим методам определения движения относятся методы на основе вычитания фона и сравнения соседних кадров. В основе этих методов лежит сравнение текущего кадра с предыдущим или с некоторым опорным кадром. При этом для вычисления разницы между кадрами можно использовать три основных подхода к вычислению компонент: на основе компонент цветовой модели RGB, на основе яркости пикселей, на основе хроматических компонент цветовой модели YUV.

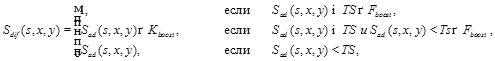

Для расчета величины движения был разработан метод, который предполагает использование факторов цветового усиления с использованием вычисления значения на основе цветовой модели RGB. Расчет абсолютной разности между значениями цветовых компонент R, G, B (Red, Green, Blue) пикселей анализируемых кадров Iop и Icur проводится в нормированном диапазоне [0…1] согласно формуле (1), с учетом расчета по цветовым компонентам, представленным в выражении (2). В качестве опорного кадра Iop можно использовать как предыдущий, так и фоновый кадр.

(1)

(1)

где s – указатель компоненты цветовой модели (R, G, B); x и y – пространственные координаты; Fboost – величина, определяющая степень активации режима усиления; Kboost – коэффициент усиления; TS – пороговое значение, которое определяет, произошли ли изменения в цвете пикселя; Sad(s, x, y) – функция вычисления абсолютной разницы по указанной цветовой компоненте между заданными кадрами, которая вычисляется по формуле

(2)

(2)

где SvIop, SvIcur – значения компоненты цветовой модели (R, G, B) опорного и текущего кадров соответственно.

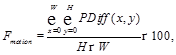

Для расчета величины изменения пикселя в нормированной форме цветовой модели RGB используется формула

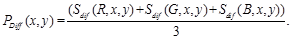

(3)

(3)

Зачастую шум в кадрах может быть засчитан как изменение в пикселе, и в итоге в большом количестве этот шум будет оказывать влияние на величину движения. Для уменьшения влияния шума на величину движения необходимо выполнить дополнительную коррекцию. Она осуществляется в зависимости от установленного порогового значения [TS] и коэффициента подавления малых отклонений [Lc] согласно формуле

(4)

(4)

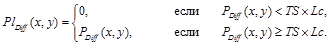

Параметр коэффициента подавления малых отклонений вычисляется на основе экспериментальных исследований и может быть скорректирован во время настройки параметров системы. Общая величина, характеризующая изменения пикселя [PDiff(x, y)], рассчитывается по формуле

(5)

(5)

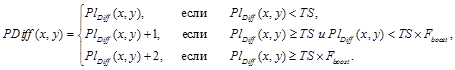

Значение величины, характеризующей движение между двумя кадрами (изменения в кадре), вычисляется на основании общей величины, характеризующей изменение значений пикселей анализируемой области кадра, согласно формуле

(6)

(6)

где W, H – размеры анализируемой области кадра по горизонтали и вертикали (ширина и высота) соответственно.

Для классификации движения используется значение величины, характеризующее движение между двумя кадрами, при этом следует отметить, что в зависимости от сцены диапазоны классификации движения могут варьироваться.

Алгоритм временного шумоподавления

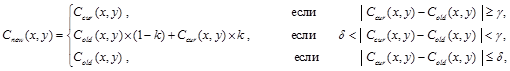

Современные CMOS-матрицы IP-камер генерируют большое количество цифрового шума в зависимости от условий освещения и таких параметров, как чувствительность матрицы, качество матрицы и объектива, настройки параметров камеры. Уменьшить их влияние можно с помощью методов подавления шумов с минимальным искажением наблюдаемых объектов. Поскольку системы видеонаблюдения анализируют видеопоток, появляется возможность удаления шумов с использованием хронологии кадров (временная фильтрация) с последующей стабилизацией цветовых характеристик фонового изображения:

(7)

(7)

где Cold – матрица значений компонентов цветовой модели для пикселей опорного кадра (по выбранной модели); Ccur – матрица значений компонентов цветовой модели для пикселей текущего кадра; Cnew – матрица новых значений компонентов цветовой модели текущего кадра; δ – минимальный коэффициент выполнения коррекции (рекомендуется выбирать 1–2 % от динамического диапазона яркости); γ – верхний порог выполнения коррекции (рекомендуется выбирать 6–9 % от динамического диапазона яркости); k – коэффициент совмещения значений пикселей.

Стабилизация видеоданных

Модуль стабилизации видеопоследовательности нацелен на подавление нежелательной вибрации движения вследствие механического дрожания камеры и погодных условий, а также на синтез новых изображений последовательности с учетом стабилизации траектории движения камеры. При использовании стационарных IP-камер на открытом пространстве дрожание кадра может возникать при движении камеры либо из-за влияния ветра.

Для стабилизации видеопоследовательности необходимо провести оценку движения. В различных публикациях для оценки движения предложены методы, основанные на поиске особенных точек, методы оптического потока и методы соответствия блоков. Алгоритм SIFT выполняет поиск особенных точек, основываясь на вычислении гауссиана на изображениях различного масштаба [1]. Он обнаруживает надежные точки и для каждой из них строит дескриптор, не зависящий от поворота, переноса и масштабирования. Частотные методы оценки движения в основном используются для глобальной оценки движения кадра. Наиболее известный из частотных методов – фазовый метод корреляции, который использует преобразование Фурье. Методы оптического потока гарантируют высокую точность для сцен с маленькими смещениями, но допускают сбои при больших смещениях. Алгоритм SURF основан на операции свертки и использует матрицу Гессе для вычисления меры распределения [2].

Большое число работ посвящено исследованию особенностей методов, основанных на методах соответствия блоков [3]: они используют различные фильтры для уточнения оценки движения и расчета локальных векторов движения. Эти алгоритмы обычно позволяют получить хорошие результаты, но могут давать ошибочные результаты для видеопоследовательностей, содержащих большие движущиеся объекты. Это происходит потому, что они не привязывают дескриптор к блоку и не отслеживают движение объектов на последовательности кадров. Для случая статичной камеры методы соответствия блоков подходят больше других, поскольку их применение позволяет отделить движение объектов в сцене от движения собственно камеры и наиболее быстро устранить нежелательное дрожание.

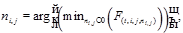

Схема блочной оценки движения содержит следующую последовательность действий. Изображение делится на неперекрывающиеся блоки пикселей Bij, где i, j – координаты блока. Для каждого блока пикселей на предыдущем кадре ищется соответствующий блок на текущем кадре [2]. Задача оценки движения сводится к задаче поиска вектора движения νi,j для каждого блока Bi,j При этом значение вектора νi,j определяется соотношением (8):

(8)

(8)

(9)

(9)

где О – область поиска векторов движения, umax, vmax – целые положительные числа; F(t,i,j,νi,j) – мера близости блоков текущего и предыдущего кадров. Примером такой функции для оценки близости блоков является SAD (Sum of Absolute Differences), определяемая формулой

(10)

(10)

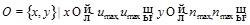

Результатом данного этапа являются рассчитанные для каждого блока изображения локальные векторы движения. Расчет глобального вектора движения производится на основе найденных локальных векторов по формуле

. (11)

. (11)

После нахождения глобального вектора движения кадра выполняется компенсация движения. На данном этапе решаются две задачи: учет глобального движения кадра, а также восстановление границ, выпавших за рамки кадра [4]. Корректировка найденного дрожания кадра выполняется путем сдвига следующего кадра в направлении, обратном найденному вектору глобального движения. Таким образом, происходит смещение изображения на несколько пикселей, при этом необходимо учитывать изменение границы кадра. Чтобы избежать потери области видимости, часть информации для граничных пикселей берется из предыдущих кадров видеопоследовательности.

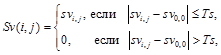

Последним этапом предлагаемого алгоритма стабилизации видео является постобработка кадра. Для нее используются автоматическая коррекция, а также обработка модифицированным для нескольких кадров фильтром 2d_cleaner. В этом фильтре для каждого пикселя изображения рассчитывается значение с учетом окрестности по формуле

(12)

(12)

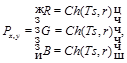

где Px,y – пиксель, с окрестностью которого ведется работа; RGB – значения каналов RGB-спектра; Ts – значение порога, характеризующего возможность обработки; r – ранг окрестности; Ch(Ts,r) – функция расчета значения канала в спектре:

(13)

(13)

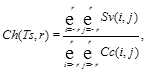

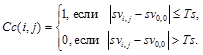

где Sv(i, j) – функция отсечения значения спектра по порогу; Cc(i, j) – функция указания пригодности значения спектра по порогу, значение которой определяется по формуле (14).

(14)

(14)

где svi,j – значение спектра рассматриваемого цветового канала; Ts – значение порога.

Реализация модифицированного фильтра 2d_cleaner выполнена с учетом обработки по временной оси нескольких кадров видеопоследовательности, что позволяет уменьшить влияние помех после стабилизации. В ходе экспериментов было выяснено, что для видеопоследовательности, полученной со стационарной IP-камеры, при выполнении такой фильтрации целесообразно использование двух или трех предыдущих кадров.

Нелинейное улучшение качества изображения

Поскольку в большинстве случаев при организации наружного видеонаблюдения встает задача улучшения визуального качества видеопотока для его лучшего восприятия оператором, в основу модуля улучшения качества изображений был положен модифицированный алгоритм Multi-Scale Retinex (MSR), имитирующий визуальную систему человека [5]. Реализация алгоритма в виде отдельного модуля предоставляет возможность через ядро системы производить улучшение визуального качества изображений в полноформатном виде только для отображаемого на экране видеопотока.

MSR-алгоритм сжимает динамический диапазон изображения с сохранением (увеличением) локального контраста в плохо и ярко освещенных областях. Классический многомерный MSR-алгоритм [6] является взвешенной суммой одномерных SSR-алгоритмов (Single-Scale Retinex) для различных масштабов. Одномерная выходная функция i-го цветового канала Ri(x, y, s) вычисляется следующим образом:

Ri(x, y, s)=log{Ii(x, y)}–log{F(x, y, s)*Ii(x, y)}, (15)

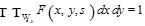

где Ii(x, y) – входная функция i-го цветового канала по координатам x и y; s – масштабный коэффициент; * – знак свертки функций; F(x, y, s) – гауссиан, определяемый как

F(x, y, s)=Ke–(x2+y2)/s2. (16)

При этом коэффициент K выбирается таким образом, чтобы выполнялось условие

, (17)

, (17)

где Wx,y – множество пикселей, принадлежащих всему изображению.

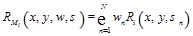

Тогда многомерная выходная функция i-го цветового канала RMi(x, y, w, s) определяется как

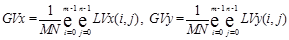

, (18)

, (18)

где w=(w1, w2, …, wm), m=1, 2, …, M – весовой вектор одномерных выходных функций i-го цветового канала Ri(x, y, s); s =(s1, s2, …, sn), n=1, 2, …, N – вектор масштабов одномерных выходных функций. При этом  .

.

Размерность вектора масштабов обычно выбирается не меньше 3. При проведении экспериментов они составили 13, 87, 180. Весовой вектор w, как правило, имеет элементы с равными значениями.

Однако классический алгоритм MSR приводит к искажению цвета изображения, так как значение каждой цветовой составляющей пикселя (например в RGB-пространстве) заменяется отношением ее исходного значения к среднему значению данной цветовой составляющей окружающих пикселей. Существует несколько решений данной проблемы. Так, некоторое улучшение результатов наблюдается при переходе в другие цветовые пространства с явным разделением яркостной и оттеночной составляющих (HIS-, HSV-, HSL-пространства). Однако лучший эффект достигается при использовании модели нормализованного разделения яркостной и оттеночной составляющих. Дополнительная обработка выполняется в соответствии с выражением

R¢Mi(x, y, w, s, b)=RMi(x, y, w, s)*I¢i(x, y, c), (19)

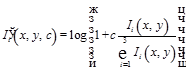

где I¢i(x, y, b) – нормализованная яркость, которая определяется по формуле

, (20)

, (20)

где c – коэффициент, выбираемый из середины диапазона значений [0…255], c=100¸125.

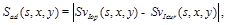

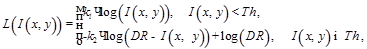

Из-за характеристик логарифмической функции MSR-алгоритм делает детали изображения более различимыми в теневых областях, чем в засвеченных [5]. Чтобы сделать детали различимыми в засвеченных областях, можно применить логарифмическую функцию к инвертированному изображению. Строится модифицированная логарифмическая функция L(I(x, y)), зависящая от порогового значения Th, выбираемого пользователем:

(21)

(21)

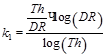

где

,

,

где DR – динамический диапазон изображения, в данном случае DR = 255 (для изображений с 8 битами на цветовой канал); k1 и k2 – весовые коэффициенты; Th – пороговое значение.

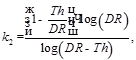

Пороговое значение Th было выбрано равным 200. Вид функции L(I(x, y)) приведен на рисунке 3.

Объединение ветвей дает классическому алгоритму MSR возможность повышать контрастность деталей в областях повышенной яркости. Использование такого вида логарифмической функции в определенной мере повышает контрастность деталей информативной области типичных распределений яркости (60–200), но в значительно меньшей мере, чем на затененных участках и участках с высокой яркостью.

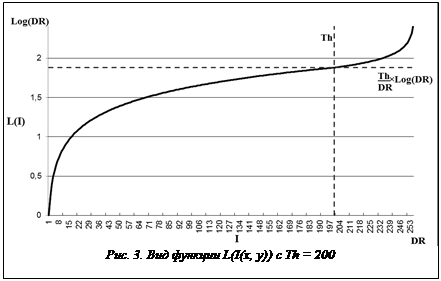

Однако выходные данные MSR-алгоритма с модифицированной логарифмической функцией находятся вне динамического диапазона изображения [5]. Чтобы привести значения к динамическому диапазону изображения [0…255], выполняется корректировка выходного изображения на основе корректирующего коэффициента и среднего значения яркостей пикселей обработанного изображения:

, (22)

, (22)

где Im(x, y) – яркость пикселя после обработки MSR-алгоритмом с модифицированной логарифмической функцией; Iavg(x, y) – среднее значение яркости пикселей обработанного изображения; wcor – корректирующий коэффициент (выбирается экспериментальным путем (wcor = 0,007), за константу С берется половина динамического диапазона изображения (С = 127,5)).

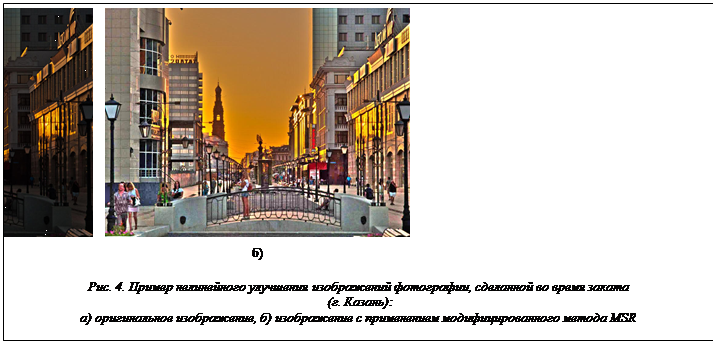

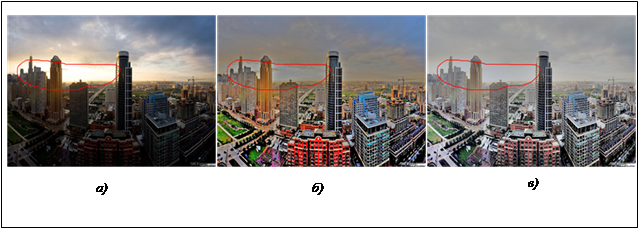

На рисунке 4 показан пример работы MSR-алгоритма с модифицированной логарифмической функцией. Сравнительный пример работы предлагаемого алгоритма с классическим методом MSR, реализованным в редакторе GIMP, показан на рисунке 5, красной линией обведена область с высокой яркостью, где, в отличие от классического метода MSR, также повышается контрастность деталей изображения.

Другие алгоритмы улучшения качества изображений

Другие алгоритмы улучшения качества изображений

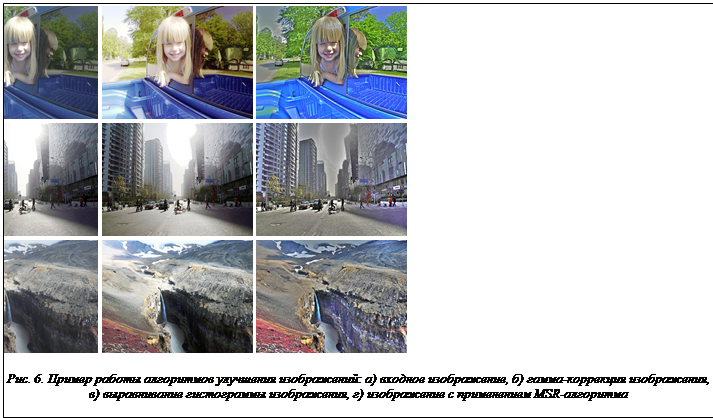

Существует множество алгоритмов улучшения визуального качества изображений, в числе самых распространенных – алгоритмы гамма-коррекции (gamma correction) и выравнивания гистограммы изображения (histogram equalization). Гамма-коррекция представляет собой изменение яркости изображения с использованием степенной функции:

(23)

(23)

где I(x, y) – яркость пикселя; gamma – коэффициент коррекции, обычно выбирается от 1,8 до 2,4 (в нашем случае использовался коэффициент 2,2, рис. 6б).

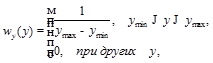

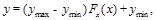

Алгоритм выравнивания гистограммы увеличивает общий контраст изображения в соответствии со следующим выражением:

|

|

|

(24) |

где ymax, ymin – максимальное и минимальное значения яркости изображения; F(x) – функция распределения яркостей входного изображения.

Для получения функции распределения яркостей измеряется гистограмма исходного изображения. Для цифрового изображения, шкала яркостей которого принадлежит диапазону [0…255], гистограмма представляет собой таблицу из 256 чисел. Каждое из них показывает количество точек в изображении (кадре), имеющих данную яркость. Пример работы алгоритма выравнивания гистограммы изображения показан на рисунке 6в.

Экспериментальные результаты

Для оценки эффективности и целесообразности использования предложенных методов было разработано экспериментальное программное обеспечение. Проверка методов обнаружения движения и сбор статистики осуществлялись с использованием видеоданных с девяти IP-камер, расположенных как на оживленных улицах, так и в местах с минимальным движением. Исследование проводилось на 57 последовательностях по 1500 кадров в каждой.

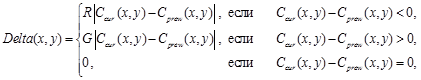

Для оценки алгоритма временного шумоподавления решено использовать метрику Delta, наглядно показывающую отличия между кадрами. Вычисление метрики выполняется согласно формуле

(25)

(25)

где Ccur – матрица значений компонентов цветовой модели для пикселей текущего кадра (по выбранной модели); Cprew – матрица значений компонентов цветовой модели предыдущего кадра; R(), G() – функции, устанавливающие значение в цветовом канале Red и Green модели RGB.

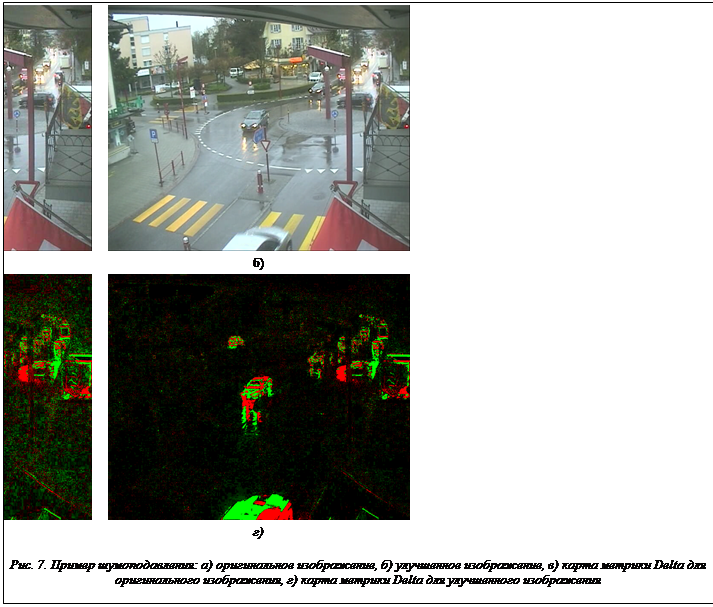

Результаты работы алгоритма временного шумоподавления с яркостной коррекцией для фрагмента видеопотока, полученного с камеры на перекрестке в городе Берн (Швейцария), показаны на рисунке 7. В ходе экспериментов было выяснено, что для динамического диапазона изображения [0…255] наиболее подходящими значениями коэффициентов будут δ=5, γ=16, k=0,4.

В разработанном методе сравнение движения проводилось при одинаковом способе вычисления величины движения, отличие заключалось в разных способах формирования значения абсолютной разницы, то есть в использовании трех основных подходов. На рисунке 8 представлен график, характеризующий величину движения для разных реализаций метода обнаружения движения на отрезке видеопоследовательности с двумя интервалами движения. Фрагмент последовательности получен с IP-камеры, находящейся на берегу залива Nordfjorden (Норвегия).

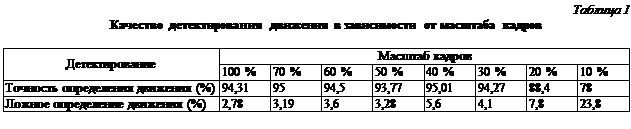

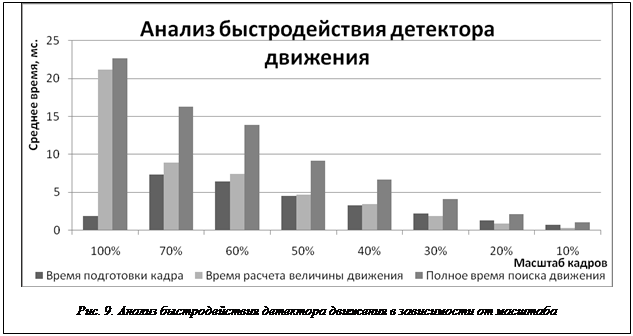

Наибольшую эффективность предложенный метод показал в цветовой модели RGB с использованием фактора цветового усиления, равного 4. Для выяснения возможности ускорения работы алгоритма вычисления величины движения был проведен ряд экспериментов. Для оценки быстродействия и точности работы детектора движения использовались кадры различного масштаба, так как уменьшение анализируемого изображения дает существенное увеличение скорости работы. В таблице 1 представлены данные о точности определения движения и уровне ложного определения движения. На рисунке 9 представлены результаты анализа быстродействия работы детектора движения в зависимости от используемого масштаба кадров. Данные результаты были получены в следующих условиях: размер кадра 640×480 на компьютере cо следующими параметрами: процессор Intel Core 2 duo 3 Ггц, ОЗУ 4Gb, видеокарта Nvidia Geforce GTS 250, операционная система Windows 7.

Тестирование разработанного алгоритма стабилизации проводилось на 15 видеопоследовательностях, полученных с доступных в открытом доступе IP-камер. Результаты оценки качества стабилизации для трех видеопоследовательностей, полученных с различными условиями съемки (рис. 10):

а)различные объекты интереса на переднем и заднем планах изображения;

б)изменение положения камеры, объекты интереса на заднем плане кадра, низкая освещенность;

в)темное время суток, высокая зашумленность кадра.

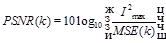

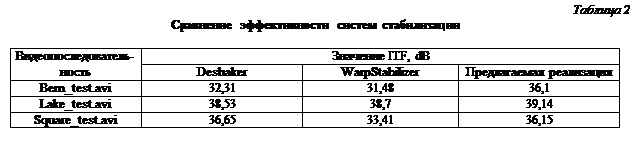

Объективная оценка качества стабилизации видеопоследовательности выполняется с использованием метрики: пиковое отношение сигнала к шуму (PSNR) как мера ошибки. PSNR между кадрами k и k –1 определяется по формуле

Объективная оценка качества стабилизации видеопоследовательности выполняется с использованием метрики: пиковое отношение сигнала к шуму (PSNR) как мера ошибки. PSNR между кадрами k и k –1 определяется по формуле

, (26)

, (26)

где MSE(k) – среднеквадратичная межкадровая ошибка; Imax – максимальное значение интенсивности пикселя; M, N – размеры кадра.

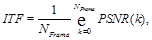

Значение PSNR показывает, насколько одно изображение похоже на другое, что полезно для оценки качества стабилизации простым сравнением соседних кадров. Качество межкадрового преобразования Inteframe Transformation Fidelity (ITF) используется для объективной оценки эффективности алгоритма стабилизации: стабилизированная видеопоследовательность должна иметь более высокое значение ITF, чем оригинальная:

(27)

(27)

где NFrame – количество кадров видеопоследовательности.

В таблице 2 приведены результаты оценки качества стабилизации ITF, рассчитанной с применением метрики PSNR для представленных на рисунке 10 видеопоследовательностей. Для сравнения использовались VirtualDub MSU Deshaker filter и фильтр для стабилизации Warp Stabilizer, встроенный в Adobe After Effects CS 5.5.

В таблице 2 приведены результаты оценки качества стабилизации ITF, рассчитанной с применением метрики PSNR для представленных на рисунке 10 видеопоследовательностей. Для сравнения использовались VirtualDub MSU Deshaker filter и фильтр для стабилизации Warp Stabilizer, встроенный в Adobe After Effects CS 5.5.

В зависимости от типов движения, присутствующих на видеопоследовательности, достигаются различные результаты стабилизации. Предлагаемый алгоритм дает наилучшие результаты при наличии возможности указать области, где отсутствует резкое движение объектов, что позволяет исключить ошибки в нахождении траектории движения камеры.

В ходе оценки качества стабилизации c применением пространственно-временного фильтра 2D Cleaner выяснено, что при стабилизации видеоматериала модифицированная реализация 2D Cleaner значительно улучшает качество, устраняя следы мелкого дрожания видеопоследовательности, от которого не удалось избавиться при стабилизации (рис. 11). PSNR-значение стабилизированной последовательности заметно выше, что показывает меньшую разницу между кадрами (более низкое дрожание кадра). Также при применении временного фильтра PSNR-значение видеопоследовательности увеличивается в пределах 30 %.

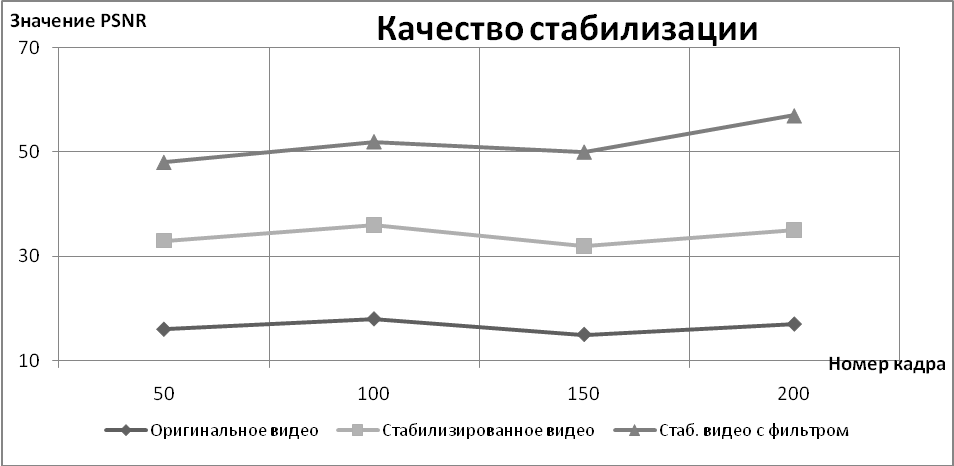

Проверка модуля улучшения визуального качества выполнялась на последовательностях, содержащих искажения, вызванные различными природными явлениями и условиями освещения. Примеры работы модуля показаны на рисунке 12. Представлены фрагменты с камер, расположенных в Лас-Па́льмас-де-Гран-Кана́рия (Испания) (съемка происходит в пасмурную погоду), в Капфенберге (Австрия) (съемка в нормальную погоду, наблюдается засветка в области гор), на берегу залива Nordfjorden (Норвегия) (съемка в туманную погоду).

Предлагаемая система видеонаблюдения с возможностью улучшения визуального качества позволит повысить эффективность работы службы охраны благодаря возможностям улучшения визуального качества отображаемых данных и стабилизации видеопотока. Предложенные детектор движения и временная фильтрация позволяют более качественно оценивать ситуацию в наблюдаемой зоне. При изменении масштаба от 100 % до 30 % фактор движения, характеризующий точность определения движения, находится на близком уровне, а при масштабе менее 15 % значительно ухудшается. Использование стабилизации видеопотока позволяет повысить качество нахождения движения в среднем на 2–7 % в зависимости от степени дрожания камеры, поскольку оно оказывает значительное влияние на работу алгоритма, а также улучшить возможности визуального наблюдения для оператора.

Литература

- Lowe D. Intern. Journ. of Computer Vision, 2004, 60(2), pp. 91–110.

- Bay H., Ess A., Tuytelaars T., Van Gool L., Computer Vision and Image Understanding, 2008, Vol. 110, pp. 346–359.

- Rawat P., Singhai J., SIPIJ, 2011, Vol. 2, no. 2, pp. 159–168.

- Ko-Cheung H., Wan-Chi S., IEEE Transactions on Image Processing, 2007, Vol. 16 (5), pp. 1232–1245.

- Фаворская М.Н., Зотин А.Г., Пахирка А.И. Метод улучшения цветных изображений на основе выравнивания спектральных диапазонов и коррекции контрастности // Механика, управление и информатика. М.: ИКИ РАН, 2012, № 8, с. 99–103.

- Choi D.H., Jang I.H., Kim M.H., Kim N.C., Proc. IEEE Int. Symp. Circuits and Syst., New Orleans, USA, 2007, pp. 3948–3951.

Comments